Contexto

Contexto

¿Por qué construyen un data center en tu territorio?

La respuesta es una mezcla de razones económicas, geopolíticas y técnicas. Aquí te contamos qué es un data center, cómo estas infraestructuras se han vuelto intencionadamente relevantes en la economía digital y por qué nuestros gobiernos se obsesionan para que se instalen en sus países.

¿Es todo tan viable e inevitable como pintan?

La nube es un data center: definiciones claves para su funcionamiento

¿Has observado a la nube digital donde ocurre la magia que permite que nuestras aplicaciones e información estén siempre disponibles en microsegundos?

La nube digital existe, pero no es como se suele imaginar. La nube no está en el cielo sino en la tierra, en los vecindarios de barrios industriales, en tierras indígenas, en desiertos y en zonas frías. Y entre más digitalizada está nuestra vida, más abundan en los países del mundo. La nube no es inmaterial sino que es una infraestructura de concreto que, si se agudiza la mirada se puede observar en varios lugares.

La nube no es una nube; la nube es un data center.

Acá muestras de la nube - los centros de datos- en Suecia, Estados Unidos y Chile.

1. Definiciones a través de tres dimensiones

No importa el lugar geográfico donde se ubiquen: suelen ser edificios gigantescos, bastante similares entre sí y muy anodinos. Es que, como se aprecia, la arquitectura física de los centros de datos no es un área especialmente fascinante de los avances arquitectónicos y tienden a ser, por lo general, poco llamativos a propósito. Los desarrolladores de centros de datos prefieren mantener sus instalaciones seguras y fuera de la vista del público. Lo anterior hace que no sea muy común saber de qué se tratan estas infraestructuras y para qué sirven. Para explicarlo mejor quizás es mejor verlo en tres dimensiones: en el papel que juegan para que internet sea posible, como infraestructuras con un funcionamiento propio, y como una tipología comercial, que hoy los convierte en un sector clave de la economía digital.

a. Data centers en la infraestructura de internet

En lenguaje muy simple, se puede pensar que internet, para que funcione, necesita tres niveles de infraestructura.

Primero las redes, que son en general lo que llamamos infraestructura de telecomunicaciones y que permite el funcionamiento del internet al posibilitar la transmisión de datos a través de redes físicas (como fibra óptica) y redes inalámbricas (como Wi-Fi, 4G, 5G y satélites).

Pero para que internet llegue desde las redes de telecomunicación al usuario final a través de sus dispositivos como teléfonos inteligentes y computadoras, se necesitan los centros de datos. Estos son claves, porque permiten un flujo de datos continuo y seguro entre redes y usuarios, haciendo posible la operación de servicios en línea, la escalabilidad de los recursos y el acceso global a información a través de su robusta conectividad, gestión y seguridad física y virtual. Actúan como centros neurálgicos que alojan servidores y equipos, conectándolos eficientemente para responder a las demandas cambiantes de los usuarios y las organizaciones

Y como se desprende, entre más digitalizada nuestra vida, más importante se hacen estas infraestructuras, a tal punto que hoy desempeñan un papel fundamental en el procesamiento, almacenamiento y distribución de grandes cantidades de datos, lo que los hace esenciales para la Inteligencia Artificial y el resto de la economía digital.

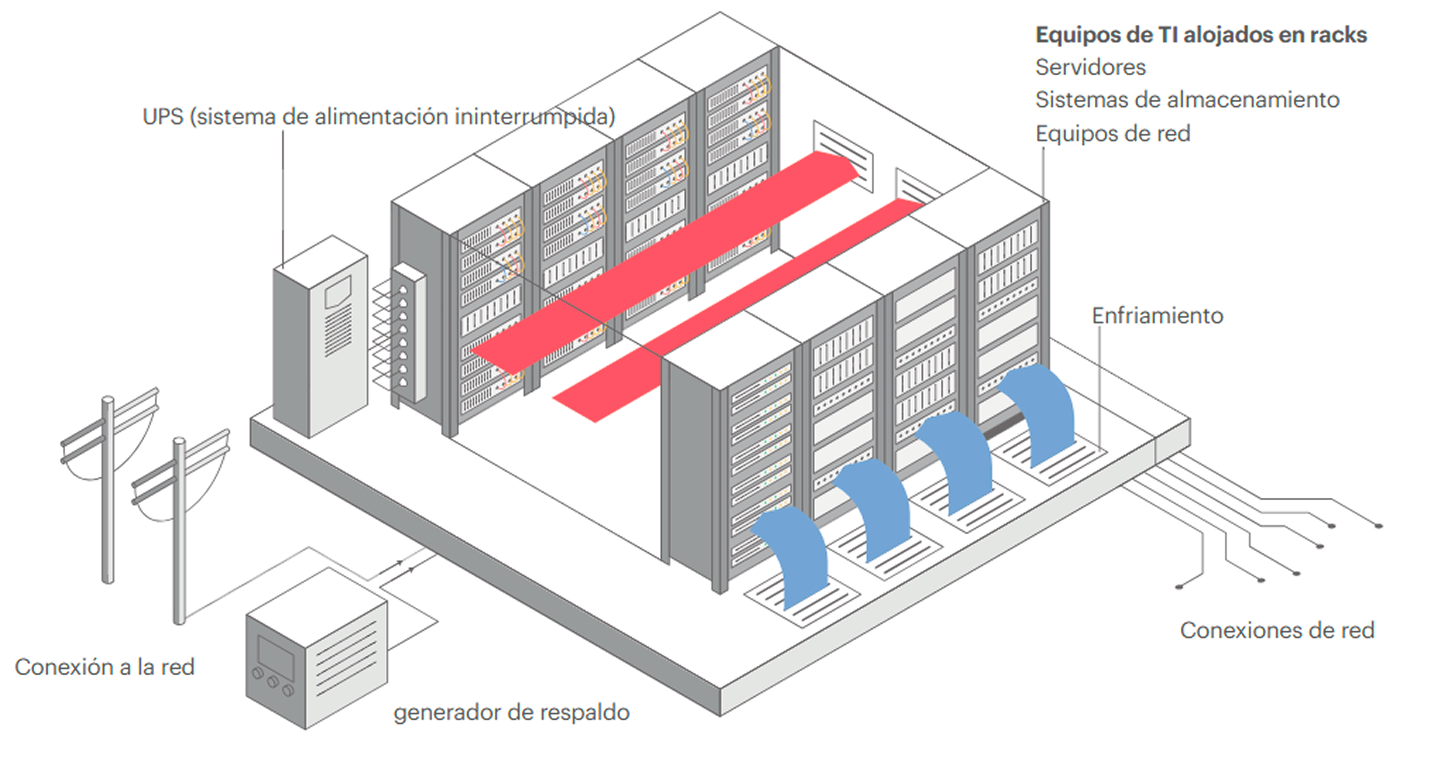

b. Data centers como instalaciones con funcionamiento propio

Una definición clásica de un centro de datos es: instalación física especializada (desde una sala a un edificio especialmente dedicado) que alberga y gestiona la infraestructura de tecnología informática (incluidos servidores, dispositivos de almacenamiento y equipos de red) necesaria para crear, ejecutar y ofrecer aplicaciones y servicios digitales.

Saber cómo funcionan los centros de data centers es clave para comprender el porqué hoy se miran críticamente sus impactos ambientales en los territorios. Para conocer cuáles, explora la sección XX en datacenterboom.net

Pero para ser más concreta la explicación de cómo funciona un centro de datos, es mejor entrar a estas instalaciones. La siguiente es una representación de una estructura básica de un centro de datos:

Al interior de estos anodinos edificios, existen una serie de componentes críticos para el procesamiento y almacenamiento de datos, y que requieren un uso intensivo de energía eléctrica para su funcionamiento las 24 horas del día, los siete días de la semana. Se trata de racks que llegan hasta el techo, uno tras otro, y que alojan:

- Servidores: computadoras que procesan y almacenan datos, equipadas con unidades centrales de procesamiento (CPU) y aceleradores especializados como unidades de procesamiento gráfico (GPU). Representan alrededor del 60% de la demanda eléctrica en centros de datos modernos

- Sistemas de almacenamiento: dispositivos para almacenamiento y respaldo centralizado de datos, que consumen alrededor del 5% de la electricidad.

- Equipos de red: computadores, enrutadores y balanceadores de carga que conectan dispositivos y optimizan el rendimiento, representando hasta el 5% de la demanda eléctrica.

Para el funcionamiento continuo de estos componentes (además de alimentar la iluminación, equipamiento de oficina y otros sistemas auxiliares), se necesita que los centros de datos tengan energía continua; de otra forma, simplemente, no puede funcionar y la nube digital se cae. Así, como parte de los equipos que existen dentro de estos edificios, se encuentran:

- Sistemas de alimentación ininterrumpida (SAI) y generadores de respaldo: garantizan la continuidad del servicio durante interrupciones eléctricas. Aunque se utilizan con poca frecuencia, son fundamentales para la fiabilidad de los centros de datos y son las principales fuentes de emisión de gases de efecto invernadero de estas infraestructuras, debido a que muchos de los generadores eléctricos de emergencia funcionan con motores de gran potencia, que operan con combustible diésel, que son preferidos por ofrecer una potencia confiable y una respuesta rápida a los cambios de carga. Un data center que usa estos tipos de generadores, es el “Datacenter PARAM” de Google, ubicado en Quilicura (Santiago, Chile), que para su funcionamiento requiere un almacenaje de 645.878 kg de combustible diésel (Evaluación Ambiental, 2017).

Para medir la eficiencia con la que un centro de datos convierte la energía total consumida en trabajo informático útil, se utiliza la métrica PUE (Power Usage Effectiveness o eficacia del uso de la energía). Esta ratio describe los gastos generales de energía de una instalación. Una PUE cercana a 1,0 significa que casi toda la electricidad alimenta directamente a los equipos informáticos. La media actual del sector es de aproximadamente 1,5.

Al funcionar constantemente, los dispositivos que están en los racks generan mucho calor en el ambiente, a tal punto, que es imperativo regular la temperatura y humedad del centro de datos para mantener los equipos informáticos en óptimas condiciones. Por eso, en las instalaciones, existen también:

Vas a necesitar prepararte un té o un café

Para conocer más a fondo cómo un centro de datos usa el agua fresca y por qué este uso sigue en medio de una gran polémica ambiental, es esencial que consultes el documento “¿Cómo usan el agua los centros de datos? Una guía breve”.

c. Data centers como tipología comercial

A pesar de esta uniformidad en su arquitectura, los data centers son diseñados específicamente para satisfacer diferentes segmentos de demanda de clientes de todo el mundo, cada uno con prioridades distintas en cuanto a latencia, tiempo de actividad, eficiencia y seguridad.

Así, responden a una gran diversidad de tipologías que suelen solaparse. Por ejemplo: por tipo de operador detrás de la empresa de centros de datos, por el grado de conectividad a Internet del operador, por el tamaño del edificio, hasta por el nivel de seguridad de la información (mediante una clasificación por niveles denominada Tier y gestionada por el Uptime Institute, donde Tier 1 es la disponibilidad menos redundante y Tier 4 es la más fiable).

Desde el punto de vista de las tipologías de quiénes son los operadores, hasta hace unos años, en general, el modelo dominante era que las mismas empresas como los gobiernos instalaran sus propios data centers, para poder cumplir con sus demandas y fines, los que en general eran gestionados por ellos mismos a través de equipos especializados. Estas instalaciones suelen estar cerca de la sede de la empresa o en una ubicación específica que cumple con sus requisitos de latencia, y, en el caso de los gobiernos, suelen estar ubicados en zonas estratégicas para beneficiarse de la seguridad militar o acceder a rutas privadas de fibra óptica del gobierno.

Pero aquel modelo ha ido cambiando en concordancia a que hoy el mercado de tecnologías digitales ha ido cambiando. Desde la década del 2010, tanto empresas como gobiernos tienden a alejarse de las instalaciones propias y optan por servicios de colocación o en la nube para aprovechar la eficiencia. Se trata, entonces, de una tipología comercial distinta. Dependiendo del tipo de centro de datos, los contratos de arrendamiento entre el propietario y el inquilino varían considerablemente, aunque, de nuevo, muchas veces estas categorías se traslapan.

Centros de datos de colocación o colocadores

Instalaciones de terceros donde las empresas o gobiernos pueden alquilar espacio para sus servidores y otro hardware informático.

Estos terceros actores, dueños de los centros de datos, alquilan el espacio físico, la energía, la refrigeración y la seguridad, al mismo tiempo que aseguran una conectividad de alta velocidad, todos elementos fundamentales para el funcionamiento de servicios digitales. Pero son los inquilinos quienes traen sus propios servidores y equipos de red o alquilan equipos al proveedor de coubicación. Por lo demás, se firman contratos de arrendamiento a largo plazo con el proveedor de colocación.

Los desarrolladores de colocación ubican las instalaciones cerca de las necesidades de sus inquilinos y donde la operación de la instalación tiende a ser económicamente viable. Las empresas más grandes en este mercado son Equinix y Digital Realty (propietaria de Ascenty en Latinoamérica).

Como se verá a continuación, las instalaciones de coubicación funcionan más como los inmuebles tradicionales que como los proveedores de nube.

Nube

Estos centros de datos de nube ofrecen recursos informáticos y almacenamiento como servicio a través de Internet. Los servicios se pueden activar y desactivar rápidamente, sin necesidad de contratos de arrendamiento a largo plazo.

La nube, en general, es operada por proveedores de servicios en la nube como Amazon Web Services (AWS), Microsoft Azure y Google Cloud, que coinciden muchas veces con las llamadas Big Tech. Pero también operadores más pequeños pueden ofrecer servicios de nube.

Estos proveedores actúan como agregadores de demanda, agrupando a muchos usuarios para lograr economías de escala. Cada vez más, las empresas optan por pasarse a la nube porque obtienen mejores rendimientos invirtiendo en sus negocios principales que en instalaciones de centros de datos. Así, en los últimos años estos proveedores -especialmente las big tech que tiene capital disponible) están optando por construir centros de datos extremadamente grandes (de hiperescala). Estos están diseñados para soportar grandes cantidades de datos y tareas informáticas.

En términos generales, los proveedores de nube generan ingresos basándose en un enfoque medido. A los usuarios se les factura en función de su uso de los servicios, incluyendo la capacidad de almacenamiento utilizada, las horas de computación, el uso del software proporcionado por la nube, etc. Los usuarios de la nube pueden ampliar o reducir su capacidad de forma rápida y eficaz, y cambiar los grandes gastos de capital iniciales y los compromisos de arrendamiento a largo plazo por gastos recurrentes en la nube.

Existen tres familias de servicios en la nube:

- IaaS (Infraestructura como servicio), que corresponde al alquiler de capacidades informáticas y de almacenamiento;

- PaaS (Plataforma como servicio), que pone a disposición de los clientes plataformas de desarrollo listas para usar con el fin de desarrollar y desplegar sus propias aplicaciones;

- SaaS (Software como servicio), que es una oferta completa de aplicaciones y software empresariales que los clientes pagan en función del tiempo de uso o del número de usuarios.

Por lo demás, una nube puede ser:

- Pública: es decir, compartida entre un número ilimitado de clientes;

- Privada: puede estar dedicada a un cliente específico, calibrada según sus necesidades.

- Híbrida: combina el uso de una nube pública (especialmente en un periodo de aumento de la carga) en un entorno de nube privada.

Hipersescala

Como vemos, los centros de datos a hiperescala se traslapan mucho con los de nube, sobre todo cuando los dueños son las big tech. La mayor diferencia es el tamaño: los data centers de nube pueden ser de cualquier tamaño, pero los de hiperescala, como dice su nombre, es una instalación de gran tamaño, diseñada para alojar cientos de miles de servidores y soportar un crecimiento masivo y acelerado de capacidad de cómputo, almacenamiento y redes. Por tal razón, suelen superar los 50 MW de capacidad y se despliegan en campus con múltiples edificios.

Generalmente pertenecen y son operados por grandes empresas tecnológicas globales como Amazon (AWS), Microsoft (Azure), Google Cloud, Meta o Apple. No venden espacio de centro de datos directamente; son la base para servicios como la Inteligencia Artificial, la nube pública, redes sociales o plataformas digitales.

Entre sus características técnicas, está su arquitectura modular, altos niveles de automatización, diseño optimizado para eficiencia energética (enfriamiento avanzado, energías renovables, hardware propio).

Periféricos (Edge)

Es importante nombrar también los centros de datos periféricos. Son instalaciones pequeñas y localizadas estratégicamente más cerca de los usuarios o las fuentes de datos. Están diseñadas para reducir la latencia en la entrega de datos, proporcionando tiempos de respuesta más rápidos y una mejor experiencia de usuario, sobre todo para aplicaciones en tiempo real y de latencia crítica. Como resultado, las empresas pueden ofrecer servicios en tiempo real, como aplicaciones IoT, streaming de vídeo, juegos y aplicaciones de realidad virtual o aumentada. Entre los usuarios se incluyen redes de distribución de contenidos (CDN), proveedores de servicios de IoT y otras aplicaciones que requieren una baja latencia.

Los edge data centers buscan monetizar la cercanía al usuario final. Sus principales modelos de negocio son que las empresas pagan por racks o espacio en centros de datos pequeños pero estratégicos (cerca de ciudades, fábricas, antenas 5G). Es decir, similar al modelo tradicional de colocación, pero en instalaciones mucho más pequeñas y repartidas. Pero los proveedores de edge ofrecen no solo espacio físico, sino también conectividad, seguridad y gestión remota. Aquí los clientes pueden desplegar aplicaciones de baja latencia sin preocuparse por operar el hardware. También, algunos operadores permiten que los clientes consuman capacidad de cómputo y almacenamiento local, con un modelo de pago por uso, similar a la nube, pero más cercano al usuario.

Además, los edge data centers sirven como nodos para operadores de telecomunicaciones, ofreciendo capacidad de cómputo en las estaciones base 5G. En vez de mandar todos los datos a un centro de datos lejano o a la nube central, el procesamiento se hace en el borde de la red, justo en la estación base o en un pequeño data center cercano. Eso permite procesar datos con latencia muy baja (milisegundos). Por ejemplo, un vehículo autónomo conectado a 5G necesita procesar imágenes de cámaras para frenar a tiempo: si mandara esos datos a un data center en EE.UU., tardaría demasiado; el procesamiento se hace en un edge data center local, conectado a la antena 5G.

Los proveedores de estos data centers arriendan ese espacio a las telcos o compartiendo ingresos en aplicaciones que necesitan baja latencia.

Data centers: una infraestructura sin arquitectura

- Una razón histórica: los centros de datos son la extensión casi orgánica de los armarios de servidores y las salas de TI incorporadas originalmente en edificios de oficinas, centros de investigación y universidades. Hoy solo cambió la escala: el armario es mucho más grande. Por lo demás, la naturaleza inicialmente descentralizada de internet favoreció la multiplicidad de actores y desarrollos descoordinados sin una visión global que pudiera haber contribuido a una reflexión arquitectónica más profunda.

- La rapidez del desarrollo de internet: cuando se creó la web comercial a principios de la década de 1990, los centros de datos se apresuraron a situarse cerca de los puntos de intercambio de Internet, cruces estratégicos de la web y de Internet. Todo se concentró muy rápidamente para ganar cuota de mercado. Muchos centros de datos se instalaron en edificios históricos de las telecomunicaciones como en edificios ya utilizados por la industria electrónica, así como antiguos emplazamientos industriales.

- Las principales empresas del sector de la coubicación (como Digital Realty, CoreSite y Equinix) son, ante todo, fondos de inversión inmobiliaria. En la década de 2000, y más aún en la de 2010, se abrió un periodo de construcción de nuevos centros de datos en edificios dedicados, pero la prioridad de los inversionistas era un rápido rendimiento de la inversión de la instalación. Es decir que se ven como costos adicionales la creación de una arquitectura especial o instalar una red de calefacción, sólo justificable si la administración donde se ubica la infraestructura ha realizado una solicitud urgente. Los centros de datos de coubicación (que, por lo tanto, excluyen los de empresas o nubes como Google o Microsoft) se han convertido en productos inmobiliarios con altos rendimientos, por lo tanto, casi nunca hay arquitectura.

- El diseño contribuye a la creación de un sistema técnico digital invisible, lo que hoy conocemos como "la nube": En otras palabras, la envoltura de la infraestructura no sugiere la importancia estratégica de su contenido, lo que contribuye a su discreción y a la creación de la nube.

Con todo, a mayor escala, algunos centros de datos se esfuerzan por integrar las instalaciones en la arquitectura y el paisaje circundantes.

El boom de los data centers en la economía del siglo XXI

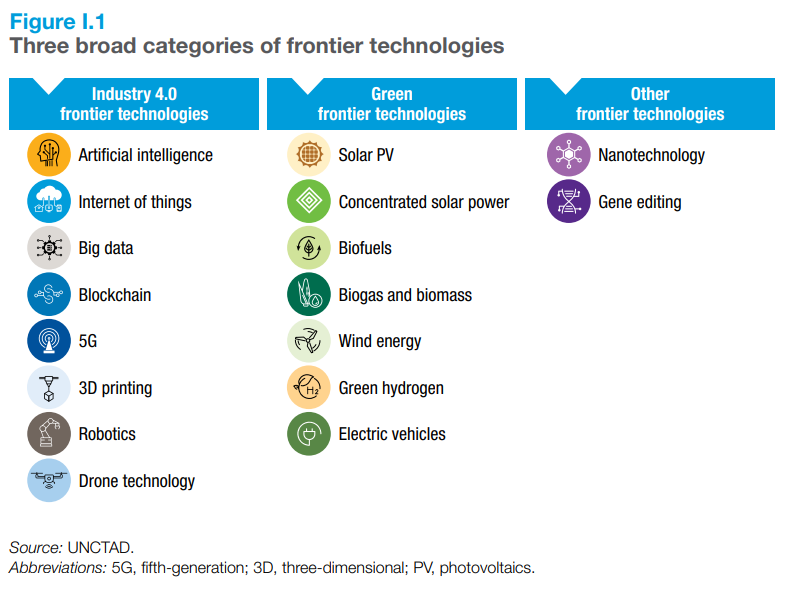

La digitalización ha cambiado para siempre la economía hasta el punto que es difícil hablar de una economía digital de otra que no lo es. Fenómenos mundiales como la pandemia COVID-19 precipitaron una digitalización de las economías para que pudieran seguir funcionando en parte. Pero, particularmente, en los últimos años, la fuerte irrupción de las llamadas “tecnologías de vanguardia”, y en particular, la inteligencia artificial (IA), están transformando profundamente nuestras economías y sociedades, reconfigurando los procesos de producción, los mercados de trabajo y las formas en que vivimos e interactuamos (UNCTAD, 2025).

1. La IA y su creciente valor en el mercado

La inteligencia artificial es la disciplina de la informática que busca desarrollar sistemas capaces de realizar tareas que normalmente requieren inteligencia humana, como el aprendizaje, la percepción, el razonamiento, la toma de decisiones y la comprensión del lenguaje.

- Se basa en algoritmos, modelos matemáticos y técnicas de aprendizaje automático (machine learning) y aprendizaje profundo (deep learning).

- Sus aplicaciones incluyen: asistentes virtuales, reconocimiento de voz e imagen, vehículos autónomos, análisis predictivo, traducción automática y chatbots avanzados, etc.

En 2023 las tecnologías de vanguardia representaron un mercado de 2,5 billones de dólares y se calcula que esta cifra se multiplicará por seis, hasta 16,4 billones, en el próximo decenio. Para el año 2033 es probable que la IA sea la tecnología de vanguardia que tenga el mayor tamaño de mercado, con unos 4,8 billones de dólares. Los continuos avances están haciendo que la IA sea más potente y eficiente, favoreciendo su adopción en muchos sectores y actividades, como la creación de contenidos, el desarrollo de productos, la codificación automatizada y la atención al cliente personalizada.

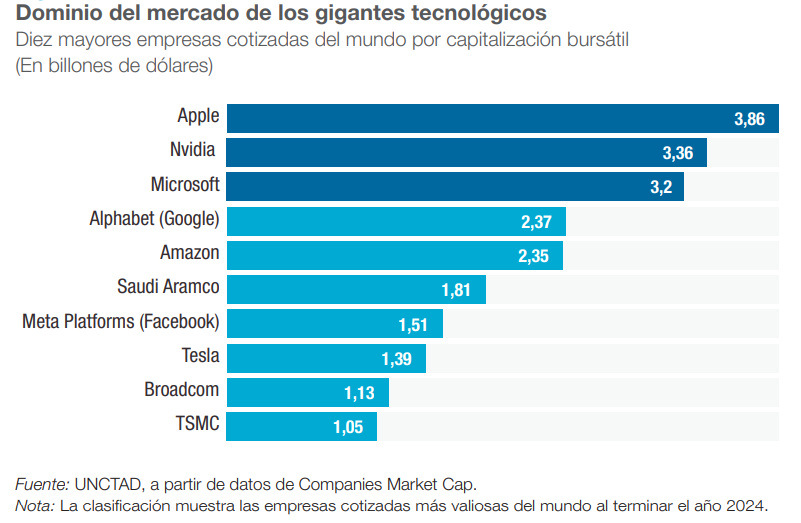

Los principales proveedores de tecnologías de vanguardia se encuentran actualmente entre las mayores empresas del mundo por capitalización bursátil. Las capitalizaciones respectivas de Apple, Nvidia y Microsoft superan los 3 billones de dólares, cerca del producto interno bruto (PIB) del continente africano, o el del Reino Unido de Gran Bretaña e Irlanda del Norte, la sexta economía más grande del mundo. Las cinco empresas más grandes son de los Estados Unidos de América, y tres de los principales fabricantes de chips —Nvidia, Broadcom y TSMC2 — se encuentran entre las diez más grandes del mundo; casi todas se centran en las tecnologías de vanguardia y están realizando grandes inversiones en la IA.

También existe una importante concentración de la inversión en investigación y desarrollo (I+D). En 2022, el 40 % de la I+D financiada por empresas en todo el mundo se concentró en solo 100 empresas, de las cuales alrededor de la mitad tenían su sede en los Estados Unidos, encabezadas por Alphabet, Meta, Microsoft y Apple. El dominio del mercado, tanto a nivel empresarial como nacional, podría ampliar las brechas tecnológicas mundiales, dificultando aún más que los rezagados recuperen el terreno perdido.

2. La IA como lucha geopolítica

Hoy somos testigos de la lucha geopolítica a contrarreloj entre Estados Unidos y China (mucho más atrás y sin estar en la competencia real está el bloque de la Unión Europea) para conquistar la supremacía económica en este escenario, en lo que se ha denominado mañosamente como “la carrera de la Inteligencia Artificial”. La competencia estratégica en torno a la IA se caracteriza por el aumento de las barreras comerciales, las ambiciones competitivas en materia de IA y la lucha por asegurar el control de los datos y las herramientas digitales del futuro.

La rivalidad estratégica entre Estados Unidos y China en torno a la IA se ha profundizado, dando lugar a conversaciones sobre una nueva «Guerra Fría digital». Ambas superpotencias consideran el liderazgo en IA un elemento definitorio del poder nacional y están movilizando recursos estatales para asegurarlo.

En este contexto, en los últimos tres años, Estados Unidos ha impulsado una estrategia integral para fortalecer su liderazgo global en inteligencia artificial. Por ejemplo, con la CHIPS and Science Act (2022) destinó más de 52.000 millones de dólares a manufactura e I+D en semiconductores, asegurando el insumo clave para entrenar modelos de frontera. En 2023 se impusieron controles de exportación de chips de IA hacia China, ampliados para cubrir modelos como Nvidia A800 y H800, con el fin de limitar el acceso de competidores estratégicos a tecnología avanzada (CNN, 2023). En 2025 (AP), la administración Trump revocó la EO 14110 y la reemplazó por la Orden Ejecutiva “Removing Barriers to American Leadership in AI”, que revoca la política previa para priorizar la desregulación y el crecimiento rápido, aunque mantiene los controles tecnológicos como principal herramienta de seguridad —un enfoque reforzado por un polémico acuerdo que permite exportar chips de IA a China, con una comisión del 15 % para el gobierno estadounidense (AP, 2025)-.

A pesar de los esfuerzos de Estados Unidos por mantener su superioridad tecnológica restringiendo el acceso de China a chips avanzados para IA, el país asiático ha logrado avances sorprendentes. El control de exportaciones debería haber mantenido una ventaja de 2–3 años para EE.UU., pero ya no parece suficiente, ya que empresas como Alibaba y Tencent han hecho progresos significativos (Time, 2025). Entretanto, China está apostando fuerte por llevar la inteligencia artificial del laboratorio al mundo real, posicionándola como herramienta clave en sectores como la salud, la seguridad pública, la educación e incluso el combate a la corrupción. Mientras tanto, el enfoque estadounidense sigue centrado en desarrollar modelos de IA de última generación, en contraste con la estrategia china que prioriza el uso tangible, el gobierno generalizado y la colaboración abierta. Aunque hay entusiasmo por el ritmo de avance, persisten dudas sobre si la infraestructura y el capital disponible en China serán suficientes para sostener el impulso estratégico (The Washington Post, 2025).

El resultado es un ecosistema tecnológico global cada vez más fragmentado. Los aliados de EE. UU. en Europa y Asia se ven presionados a tomar partido o dividir sus cadenas de suministro. Muchos se han alineado hasta cierto punto con las restricciones estadounidenses a las exportaciones de China, pero pocos se sienten cómodos con una ruptura total, dado el papel de China como mercado y proveedor (WEF, 2025).

Del mismo modo, en medio de esta lucha geopolítica, como ratifica el informe sobre IA de la UNCTAD (2025) existe una importante brecha en materia de IA entre los países desarrollados y los países en desarrollo. En cuanto a las infraestructuras, por ejemplo, los Estados Unidos poseen alrededor de un tercio de las 500 mayores supercomputadoras y más de la mitad del rendimiento computacional global.

La mayoría de los centros de datos también se encuentran en los Estados Unidos. Aparte del Brasil, China, la Federación de Rusia y la India, los países en desarrollo tienen escasas infraestructuras de IA, lo que dificulta su capacidad para adoptar y desarrollar esta tecnología. La brecha de IA también es evidente en términos de proveedores de servicios, inversión y creación de conocimientos.

Tratando de no quedarse estancado en esta evidente brecha en las economías digitales dominadas por la IA, el resto de países, mientras tanto, con prisa también buscan tener presencia en la cadena global de producción de la IA.

Este último es el caso de América Latina donde los gobiernos apuran las condiciones de inversiones de los grandes jugadores de la IA. Pero la presencia de nuestro continente en la cadena global de producción en la economía del siglo XXI se parece mucho a la del siglo XX: ofrecer recursos naturales a bajo precio.

Ya sea los metales y minerales que están presentes en los microchips y otros componentes computacionales, a la mano de obra, la tierra, el agua y la energía renovable barata para alimentar los centros de datos: nuestra presencia en la cadena global no ofrece mucho valor agregado y, a cambio, recibe pocos empleos, enfrenta las consecuencias socioambientales graves y, por cierto, termina pagando un gran precio por la misma tecnología que, en muchos aspectos al menos materiales, sostenemos. Como dijo la UNCTAD en su informe sobre economía digital y sostenibilidad (2024): "En este contexto, es fundamental corregir los desequilibrios comerciales según los cuales los países en desarrollo exportan minerales en bruto e importan manufacturas de mayor valor agregado, lo que se traduce en un intercambio ecológico desigual".

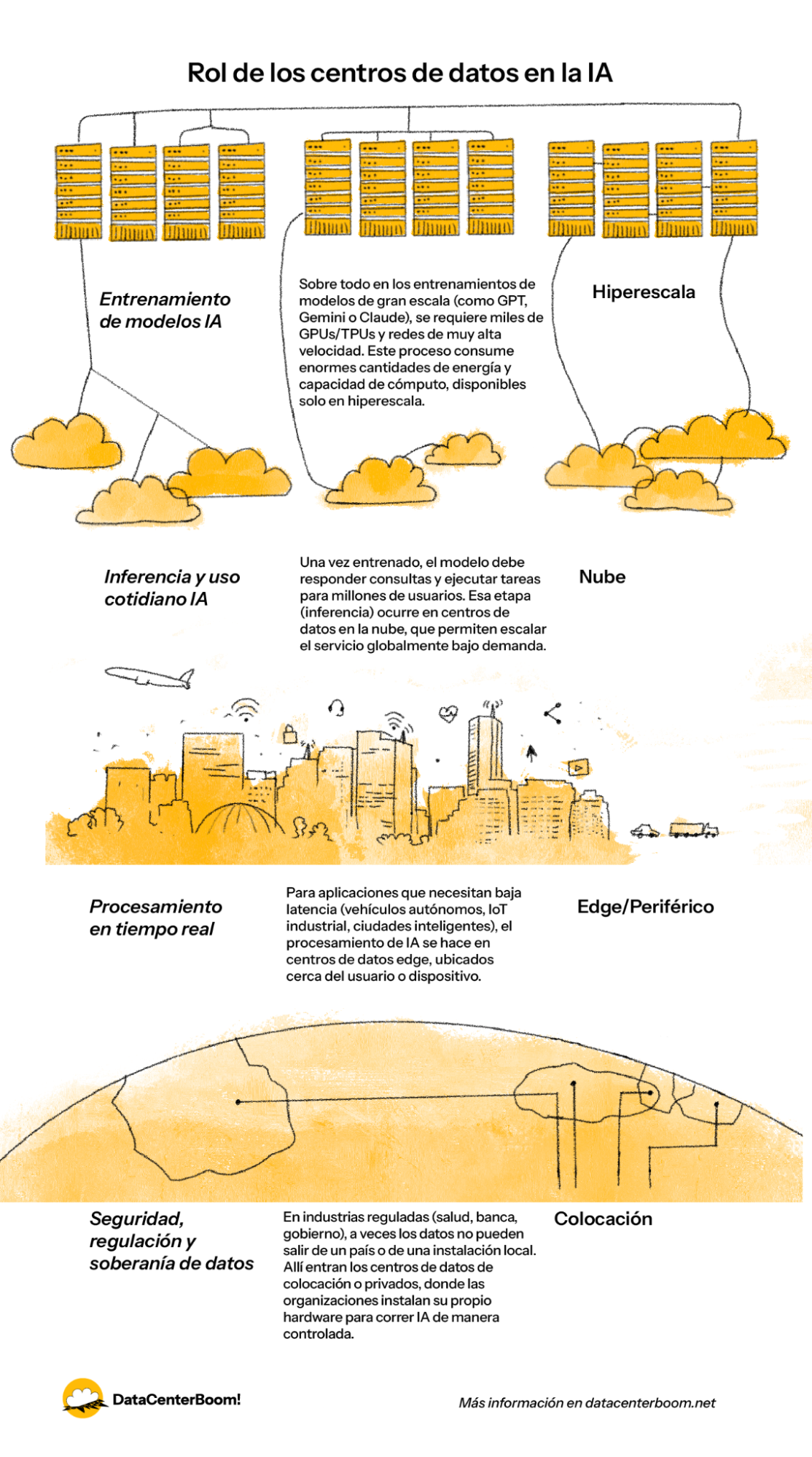

3. El rol de los data centers en la IA

Este es el contexto geopolítico que explica el porqué crecientemente los países de América Latina se pelean por ser un espacio atractivo para que los centros de datos para la IA se instalen en sus países: los centros de datos se consideran un activo de primer orden en la economía digital (Valdivia, 2024).

Los centros de datos son ahora infraestructuras críticas en la economía digital global. Estas extensas granjas de servidores gestionan más del 95 % del tráfico de internet mundial , lo que sustenta todo, desde la transmisión de vídeo hasta los servicios de inteligencia artificial en la nube. Y es que, ya sea para entrenar o para usar sus algoritmos, la IA requiere, además de una infraestructura de conectividad (telecomunicaciones), una infraestructura digital de cómputo robusta, entendida como el conjunto de tecnologías y sistemas que permiten la creación, procesamiento, almacenamiento y transmisión de datos.

Para la WEF (2025), los centros de datos, considerados en el pasado como infraestructura de back-end, se han convertido en activos estratégicos: el equivalente digital de las centrales eléctricas o los puertos.

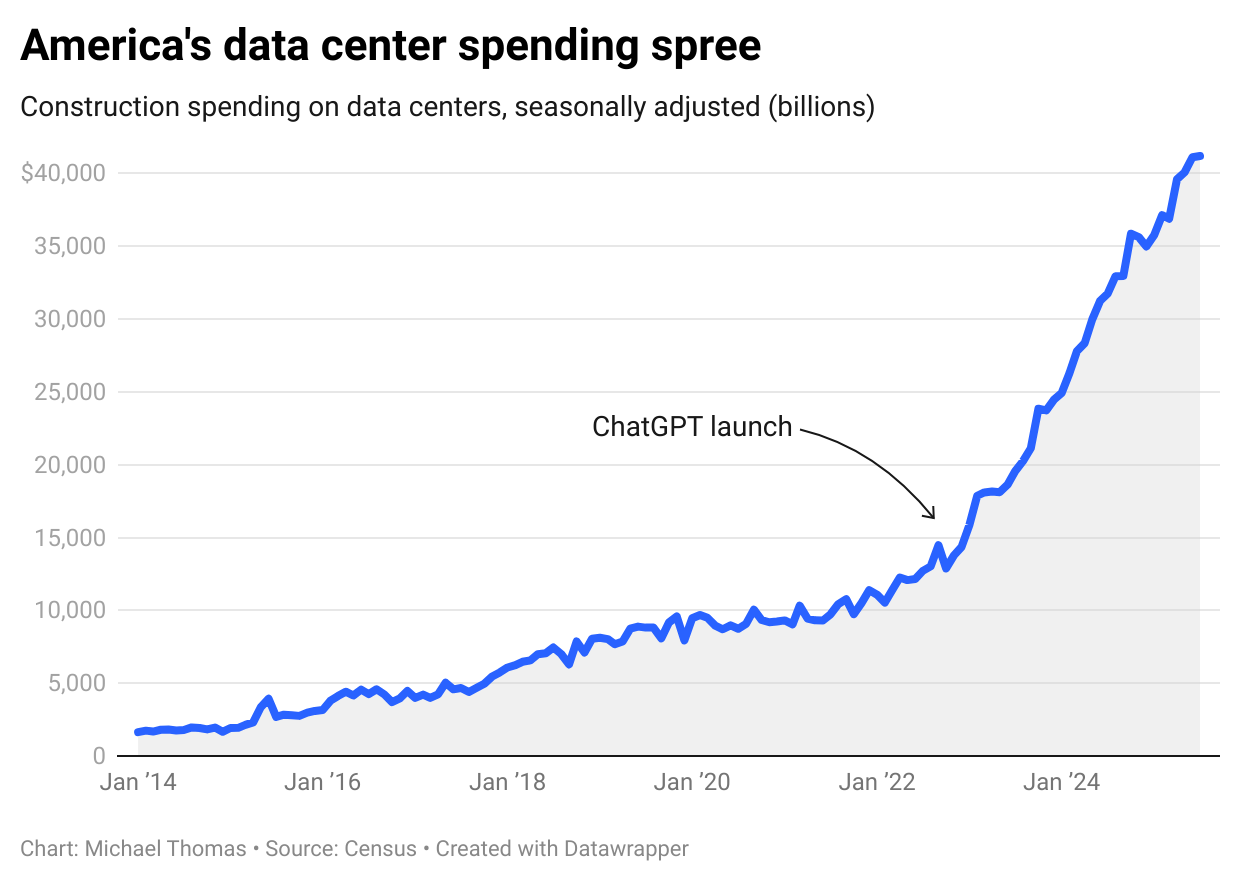

Ahora bien, desde el lanzamiento de ChatGPT en noviembre de 2022, las empresas tecnológicas han invertido enormes sumas de dinero en la construcción de centros de datos. Como notifica Michael Thomas (2025), en solo tres años, el gasto en centros de datos en Estados Unidos ha pasado de 13 800 millones de dólares a 41 200 millones de dólares al año, lo que supone un aumento del 200 %. Esto ha ocurrido en un momento en el que prácticamente todas las demás actividades de construcción en el país se han ralentizado.

Solo Estados Unidos alberga aproximadamente el 51% de los centros de datos del mundo, una concentración que pone de relieve tanto el dominio digital del país como la dependencia de otros países de las nubes estadounidenses. Este dominio ha impulsado a muchas otras naciones y regiones a acelerar el desarrollo de su propia capacidad de centros de datos, con el objetivo de garantizar que sus datos residan en su propio territorio.

Por lo tanto, los centros de datos se han convertido en un foco de atención de la política industrial. En todo el mundo, los países ofrecen incentivos fiscales y permisos acelerados para atraer nuevas granjas de servidores. Las economías emergentes consideran los centros de datos como la base del crecimiento futuro, lo que atrae a las grandes empresas tecnológicas a establecer centros regionales.

El objetivo no es solo económico, sino también de resiliencia digital. Albergar un gran centro de datos puede atraer industrias afines, como los servicios en la nube y la investigación en IA, a la vez que reduce la dependencia de la conectividad extranjera. En una crisis, controlar el almacenamiento de datos nacional podría ser tan importante como controlar el suministro de energía.

Sin embargo, esta nueva importancia conlleva una nueva vulnerabilidad. Las tensiones geopolíticas ensombrecen la industria de los centros de datos, ya que las cadenas de suministro de componentes críticos —desde chips avanzados hasta cables de fibra óptica— se ven ahora envueltas en disputas comerciales.

Los controles y sanciones a las exportaciones pueden obstaculizar el acceso a los procesadores más modernos necesarios para el funcionamiento de los centros de datos modernos. Por ejemplo, los chips de IA de alto rendimiento fabricados por empresas estadounidenses se han visto afectados por prohibiciones de exportación, lo que ha obligado a los operadores chinos a buscar alternativas.

Estas restricciones ponen de relieve que un centro de datos es tan avanzado como los componentes que puede importar, lo que lleva a estas instalaciones desde las trastiendas de la tecnología al primer plano de las preocupaciones de seguridad global.

Sobre las políticas públicas de los gobiernos que se despliegan en América Latina, explora la sección “¿Cómo responde la política pública a los impactos socioambientales de los centros de datos?” en datacenterboom.net

¡Boom! ¿Es esto una burbuja?

"Data Center Market Size And Share | Industry Report, 2030" (2025) de Grand View Research, afirma que el mercado global de data centers en el 2024 fue valorado en aproximadamente USD 347.60 mil millones. Para el 2030 se espera que alcance USD 652.01 mil millones para 2030, con una tasa de crecimiento anual compuesta (CAGR) del 11.2 % entre 2025 y 2030. El crecimiento se debe, principalmente, a la expansión de transformación digital, la adopción de computación en la nube, e implementación de tecnologías emergentes como inteligencia artificial (IA), aprendizaje automático (ML) y el Internet de las Cosas (IoT). Norteamérica tuvo la mayor participación del mercado en 2024, con más del 40 % del total. Asia-Pacífico fue la región con el crecimiento más rápido.

Pero el crecimiento acelerado de los centros de datos, especialmente en Estados Unidos, están vinculados al boom en las economías globales de la inteligencia artificial. Tanto ésta como sus infraestructuras derivadas, en especial, los data centers, han sido cuestionados: ¿serán la próxima burbuja económica que, en medio de tanta especulación financiera, hagan estallar a las economías?

Para muchos autores como el columnista de economía y negocios de The New Yorker, John Cassidy (2025), hay indicios suficientes para comparar el actual entusiasmo por la inteligencia artificial con la burbuja puntocom de los años 90, destacando similitudes como inversiones especulativas desmesuradas, salidas a bolsa espectaculares y valoración elevada sin respaldo claro en beneficios reales. Si bien, a diferencia de la era puntocom, hay grandes empresas como Nvidia, Microsoft y Apple que muestran ganancias robustas, hay señales preocupantes: Palantir alcanzó una valoración cercana a 600 veces sus ganancias y 130 veces sus ventas, cifras que incluso en la burbuja puntocom habrían levantado sospechas Además, la oferta pública inicial de Figma se disparó un 250 % en un solo día, evocando actuaciones similares de la década de 1990.

La duda sobre la burbuja se extiende a la fiebre por construir centros de datos para la IA. Diversas fuentes coinciden en que la expansión masiva actual en Estados Unidos refleja tanto el entusiasmo por la IA como riesgos potenciales de burbuja financiera e infraestructura. Por ejemplo, se advierte que muchos de estos proyectos se financian sin claridad sobre la rentabilidad futura (Futurism, 2025). Joe Tsai, presidente de Alibaba, declaró que ya se perciben señales de una burbuja: muchos centros de datos se construyen sin contratos que aseguren clientes. Criticó particularmente las inversiones masivas en EE. UU., de cientos de miles de millones de dólares, basadas más en expectativas que en demanda comprobada (Quartz, 2025). Efectivamente, Estados Unidos está viviendo una “fiebre del oro” en la construcción de centros de datos. Sin embargo, la falta de coordinación entre el gobierno federal y los estados amenaza con generar inversiones duplicadas, tensiones en comunidades locales y costos públicos poco sostenibles (Atlantic Council, 2025). Como contrapunto, para otras fuentes la demanda de capacidad de cómputo para IA sigue siendo sólida, pero lo que se observa es una pausa estratégica en algunos proyectos por parte de las grandes tecnológicas, más orientada a reorganizar inversiones que a un freno definitivo (CNBC, 2025).

En medio del auge de la inteligencia artificial, por su parte China puso en marcha cientos de proyectos de centros de datos entre 2023 y 2024: más de 500 anunciados y al menos 150 operativos a finales de 2024. Muchos de ellos están ahora infrautilizados debido a una mala planificación, a los cambios en la demanda (por ejemplo, el paso de las cargas de trabajo de entrenamiento a las de inferencia) y a problemas técnicos. Las instalaciones se han convertido en cargas costosas con un bajo nivel de utilización (MIT Technology Review, 2025). Es más, fuentes locales informaron de que hasta el 80 % de la capacidad de los centros de datos de IA recién construidos en China permanece ociosa (TechRadar, 2025).

Con todo, los centros de datos son una de las clases de activos de más rápido crecimiento en el sector inmobiliario comercial, especialmente en los mercados emergentes. Gran parte de este crecimiento se concentra en los llamados "mercados secundarios", como Latinoamérica. De hecho, según el informe “Latin America Data Center Market Landscape” (2025–2030)" de Research And Markets (2025), en 2024 el mercado de centros de datos en América Latina se valoró en USD 7.16 mil millones. Se proyecta que para 2030 alcance los USD 14.30 mil millones, lo que implica una tasa de crecimiento anual compuesta (CAGR) de 12.22%.

Como veremos en todo Data Center Boom, los centros de datos consumen muchos recursos y requieren grandes cantidades de energía, agua y terreno. Se necesita más espacio externo cerca de los centros urbanos, así como un suministro confiable de agua y energía, que nunca antes para soportar la gran cantidad de capacidades de computación y procesamiento para la IA y la tecnología 5G. Este rápido crecimiento sin precedentes ha requerido una cuidadosa planificación de infraestructura y financiación por parte de gobiernos e inversores privados. Una explosión de la burbuja, aún en Estados Unidos, sí tendría consecuencias en América Latina.

Para Alfonso Marín Muñoz (2025), experto en energía, no es descabellado hablar de una burbuja. “Ya se especula con terrenos, contratos de energía a largo plazo, y tecnologías aún no maduras como si fueran oro puro. Todo ello bajo la premisa de que la demanda digital seguirá creciendo indefinidamente. Pero, ¿y si no es así? ¿Y si se estabiliza? ¿Qué pasará cuando suba el precio de la electricidad o las reglas del juego cambien por la vía regulatoria o medioambiental?”

¿Dónde está el negocio? Los factores para decidir dónde instalar un data center

Para los operadores de centros de datos, la prioridad principal es garantizar el acceso continuo a los datos para sus clientes, lo que requiere un tiempo de actividad ininterrumpida. Esto hace que el funcionamiento ininterrumpido de las instalaciones y los sistemas auxiliares, incluidos la refrigeración, el soporte informático y la seguridad, sea absolutamente crítico. El tiempo de inactividad, al contrario del tiempo de actividad, se produce cuando se producen interrupciones en estas operaciones, lo que conlleva diversos costos económicos y consecuencias prácticas en función de los servicios que alojan.

Brindar un servicio ininterrumpido implican varias condiciones técnicas, económicas y políticas que se consideran al seleccionar un terreno para emplazar un centro de datos (Fawcett, 2024):

a. Latencia

La latencia es el tiempo que tardan los datos en viajar entre el dispositivo de un usuario y un centro de datos, normalmente medido en milisegundos, y afecta directamente a la velocidad de respuesta de las aplicaciones, los sitios web y los servicios en la nube.

La latencia es especialmente importante para la inteligencia artificial (IA), ya que muchas aplicaciones de IA requieren un procesamiento en tiempo real o casi en tiempo real. Por ejemplo, los vehículos autónomos, los robots industriales, los sistemas de detección de fraudes y los asistentes virtuales dependen de modelos de IA que deben analizar datos y responder al instante; una latencia elevada puede provocar retrasos que reducen la precisión, la eficiencia o incluso la seguridad. En el entrenamiento de grandes modelos de IA, la baja latencia entre los servidores y el almacenamiento también acelera las transferencias de datos, lo que hace que el proceso sea más eficiente. Del mismo modo, en la inferencia (cuando se aplican modelos de IA para hacer predicciones), la reducción de la latencia garantiza una experiencia de usuario más fluida en aplicaciones como los chatbots, las imágenes médicas o la realidad aumentada.

Todo dependerá de los servicios: algunos casos de uso requieren la latencia más baja posible, mientras que otras aplicaciones pueden tolerar tiempos de espera más largos.

Así, a la hora de elegir la ubicación de un centro de datos, es fundamental tener en consideración la latencia necesaria para las tareas que se quieren implementar. Los centros de datos suelen construirse cerca de grandes núcleos de población, importantes puntos de intercambio de Internet o regiones con una sólida infraestructura de conectividad. Tradicionalmente, los centros de datos han dado prioridad a la proximidad a las grandes áreas metropolitanas, cerca de la sede de la empresa o donde se espera que se acceda a los datos. Algunos casos de uso dictaminan que el centro de datos debe estar situado cerca de los usuarios; otros casos sugieren que los datos deben estar situados cerca de otros datos.

b. Redundancia

Mientras la latencia se centra en reducir los retrasos en la transmisión de datos, la redundancia garantiza un funcionamiento continuo y la resistencia frente a fallos. Así, la redundancia se centra en la confiabilidad, concretamente, en contar con sistemas de respaldo para la energía, la refrigeración y la conectividad de red, de modo que los servicios sigan funcionando incluso si falla un componente.

Un centro de datos bien ubicado que cumpla con estándares de redundancia debe poder conectarse a múltiples redes eléctricas, contar con sistemas de suministro de energía ininterrumpida (UPS) y generadores de respaldo, diseños de refrigeración redundantes como N+1 o 2N, y diversas rutas de fibra. Esto garantiza que, incluso si falla un sistema, los servicios permanezcan en línea, lo cual es vital para las cargas de trabajo de misión crítica.

c. Conectividad

La conectividad destaca la importancia del acceso a una infraestructura digital sólida. Las ubicaciones con redes de fibra densas, múltiples opciones de operadores y proximidad a los principales IXP son más adecuadas para ofrecer servicios de baja latencia y evitar cuellos de botella. La integración con la infraestructura periférica y las redes 5G también se está convirtiendo en un elemento cada vez más importante.

d. Energía

Los centros de datos funcionan con miles de servidores las 24 horas del día, lo que consume grandes cantidades de electricidad, no solo para alimentar los equipos informáticos, sino también para hacer funcionar los sistemas de refrigeración que evitan el sobrecalentamiento. Esto significa que el acceso a un suministro eléctrico estable y asequible es esencial tanto para las operaciones diarias como para la viabilidad financiera a largo plazo. Sin ella, la instalación corre el riesgo de incurrir en mayores costos, tiempos de inactividad o incluso de no poder prestar servicios a los clientes.

Más allá de la asequibilidad, la fiabilidad energética es otra consideración crucial. Los centros de datos no pueden permitirse interrupciones, ya que el tiempo de inactividad podría perturbar servicios esenciales como la computación en la nube, la banca, el comercio electrónico o la atención médica. Por esta razón, se prefieren las ubicaciones con una infraestructura energética sólida, como múltiples redes independientes, líneas eléctricas redundantes o una gran capacidad de generación de respaldo. Las zonas propensas a apagones o a un suministro eléctrico inestable pueden suponer riesgos importantes, lo que requiere costosas inversiones en sistemas de respaldo.

Al mismo tiempo, la sostenibilidad y la responsabilidad medioambiental se han convertido en aspectos fundamentales a la hora de considerar la energía. Con la creciente presión mundial para reducir las emisiones de carbono, las empresas prefieren ubicaciones donde abundan las fuentes de energía renovables, como la hidroeléctrica, la eólica o la solar. Los operadores a gran escala, como Google, Amazon y Microsoft, suelen comprometerse a alimentar sus centros de datos con energía 100 % renovable, lo que influye en la selección de la ubicación. Por lo tanto, las regiones que ofrecen opciones energéticas limpias, económicas y escalables son mucho más atractivas que aquellas que dependen de los combustibles fósiles.

Por último, los factores normativos y de reputación relacionados con el uso de la energía también son fundamentales. Los gobiernos están aplicando cada vez más las normativas medioambientales y los objetivos de reducción de carbono, lo que puede afectar tanto a la disponibilidad como al costo de la electricidad. Además, los clientes y las partes interesadas esperan que las empresas den prioridad a la energía verde, lo que hace que la sostenibilidad no sea solo una elección operativa, sino también estratégica y de reputación.

Acceso a la energía como factor de los países en desarrollo

De acuerdo a la International Energy Agency (IEA) y su informe Energy and AI (2025), si bien las economías emergentes y en desarrollo (excepto China) representan el 50% de los usuarios de internet del mundo, menos del 10% de la capacidad global de los centros de datos viene de allí.

En regiones con frecuentes cortes de energía o problemas de calidad de la misma, mantener un centro de datos puede ser arriesgado o costoso, lo que hace que el alojamiento en el extranjero resulte más atractivo para las empresas.

Esto podría ser una oportunidad para los países en vías de desarrollo con un historial de energía fiable y asequible, pues estarán en mejor posición para localizar la potencia informática que es fundamental para el desarrollo de centros de datos.

e. Disponibilidad de agua

Al igual que con la electricidad, la estabilidad del suministro de agua es importante. Los centros de datos generan enormes cantidades de calor, y muchas instalaciones dependen de sistemas de refrigeración basados en agua (refrigeración por evaporación, sistemas de agua enfriada) porque suelen ser más eficientes energéticamente que los sistemas basados exclusivamente en aire. Una fuente de agua segura y continua garantiza una refrigeración ininterrumpida y evita el sobrecalentamiento que podría provocar tiempos de inactividad o daños en los equipos. Esto significa que la proximidad a fuentes de agua confiables es una consideración importante al momento de elegir una locación.

En regiones con escasez de agua, el uso de grandes volúmenes de agua dulce para la refrigeración puede crear tensiones con las comunidades e industrias locales. Empresas como Microsoft y Google han sido objeto de críticas por el consumo de agua de sus centros de datos, especialmente en zonas propensas a la sequía. Esto ha convertido el consumo de agua en una cuestión reputacional y medioambiental, y no solo operativa.

f. Riesgos naturales

Riesgo naturales se refiere a las condiciones externas que pueden amenazar el funcionamiento de un centro de datos. Los desastres naturales, como terremotos, inundaciones o huracanes, pueden causar interrupciones en el servicio o dañar la infraestructura. También se tienen en cuenta la estabilidad política y los riesgos de seguridad, así como el clima local, que influye en los costos de refrigeración.

g. Regulación e incentivos

Por último, la regulación y los incentivos reflejan el papel de las políticas en la toma de decisiones sobre la ubicación. Las leyes de soberanía de datos pueden exigir que los datos se almacenen dentro de determinadas jurisdicciones, las regulaciones medioambientales pueden influir en el diseño y las operaciones, y las exenciones fiscales o los incentivos a la inversión pueden inclinar la balanza financiera a favor de una ubicación frente a otra.

Las restricciones normativas y de zonificación relacionadas con el uso del terreno pueden impedir o facilitar los proyectos. Algunas regiones ofrecen zonas industriales diseñadas específicamente para centros de datos, con beneficios fiscales y permisos preaprobados, mientras que otras pueden imponer regulaciones medioambientales o de ruido que ralentizan el desarrollo.

Para saber más sobre estos incentivos regulatorios, te invitamos a visitar la sección en datacenterboom.net llamada "¿Cómo responde la política pública a los impactos socioambientales de los centros de datos?" y también leer el documento “Una introducción a los impuestos de los centros de datos y sus polémicas exenciones”.

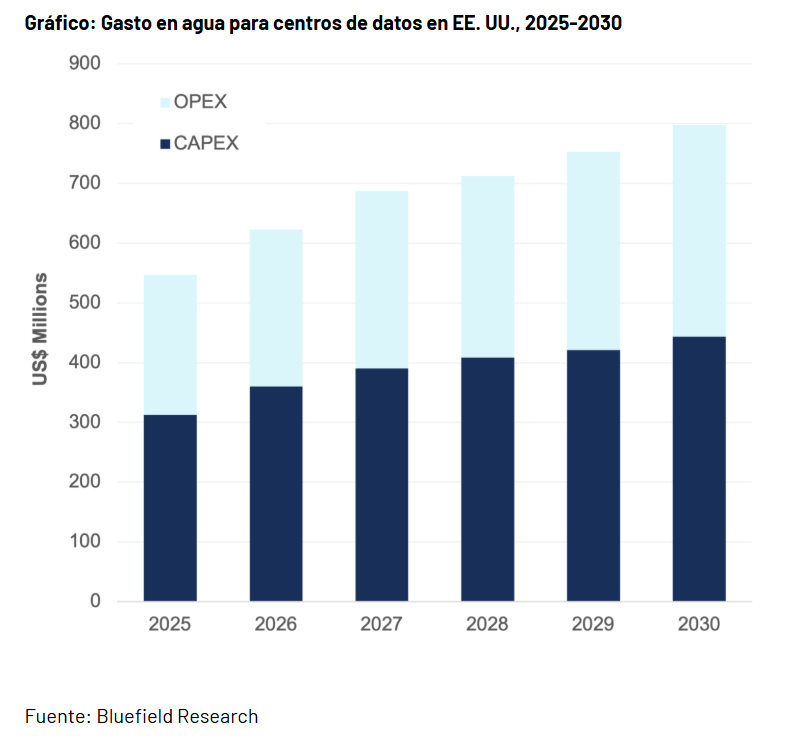

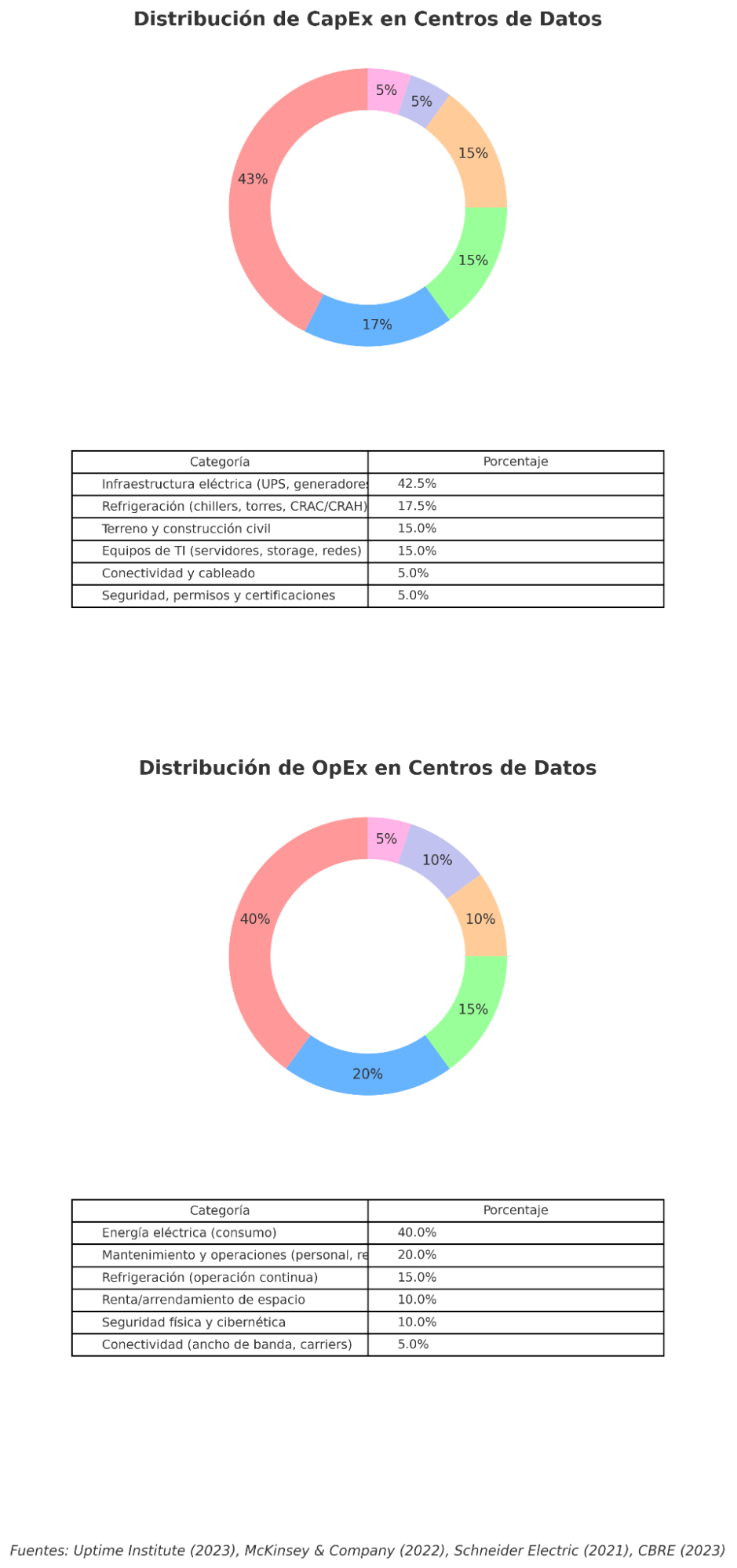

h. Costos

Los costos de un centro de datos se dividen en dos grandes categorías: CapEx (gastos de capital) y OpEx (gastos operativos). El CapEx corresponde a la inversión inicial necesaria para construir el centro de datos, mientras que el OpEx refleja los gastos recurrentes para mantenerlo en funcionamiento de forma continua y segura.

La relación entre CapEx y OpEx es estratégica: una inversión inicial más alta en tecnologías eficientes de refrigeración o en energías renovables puede reducir significativamente los costos operativos a largo plazo. En contraste, un diseño más austero con un CapEx reducido puede generar un OpEx mucho más alto, debido a un mayor consumo energético y necesidades frecuentes de mantenimiento.

i. Gatos de capital (CapEx)

En promedio, se estima que construir un centro de datos cuesta entre 7 y 12 millones de dólares por megavatio (MW) de capacidad de TI instalada, dependiendo del nivel Tier, la ubicación y el modelo de negocio (hyperscale, colocation o enterprise).

Los rubros más relevantes de estos gastos, son:

Compra de terrenos

La disponibilidad y el precio del terreno son factores clave que influyen en los costos. Los centros de datos requieren grandes parcelas para albergar salas de servidores, infraestructura de refrigeración, equipos eléctricos y, a menudo, espacio para futuras ampliaciones.

Los terrenos cercanos a redes eléctricas, fuentes de energía renovable y suministros de agua reducen los costos de infraestructura y mejoran la sostenibilidad. Del mismo modo, la proximidad a rutas de fibra óptica o puntos de intercambio de Internet garantiza una buena conectividad.

En zonas urbanas o regiones con espacio limitado, los altos costos inmobiliarios pueden hacer que los proyectos sean viables desde el punto de vista financiero. Por el contrario, las ubicaciones rurales o semirurales suelen ofrecer terrenos más baratos, pero deben ser sopesados con otros factores, como la conectividad y la latencia.

Tanto los hiperscaladores los promotores de centros de datos inmobiliarios realizan una actividad denominada "acumulación de terrenos". Acumulan terrenos en ubicaciones atractivas cinco, siete o diez años antes incluso de empezar a construir. Muchos promotores tienen cientos, sino miles de hectáreas de terreno en sus depósitos. Gradualmente, van incorporando capacidad, por lo que podrían poner en marcha un proyecto de, por ejemplo, 50 o 100 megavatios cada dos años. Esto depende en gran medida del capital disponible y de cuándo prevén que comience la cesión.

Para profundizar en el negocio detrás de la venta de terrenos para centros de datos, lee el informe "Terrenos, compras y zonificación de data centers. Una guía inicial".

Infraestructura eléctrica

Actualmente, el reto más difícil en la industria es encontrar o suministrar energía a un sitio en desarrollo. Una métrica relevante en la industria es el costo de la nueva energía (CONE, por sus siglas en inglés) o el costo asociado con el suministro de energía a un sitio. Hay tres niveles principales de infraestructura eléctrica: generación, transmisión y distribución. Pueden surgir limitaciones en cualquiera de estos tres niveles, lo que requiere mejoras para suministrar la electricidad necesaria a un sitio.

En el nivel de generación de energía, se crea la electricidad. A continuación, para transmitir eficazmente la electricidad a grandes distancias, se aumenta el voltaje, o la velocidad a la que viaja la electricidad, para reducir la cantidad de electricidad que se pierde debido a la resistencia. Las subestaciones se utilizan para aumentar o disminuir estos voltajes. Las líneas de distribución son los postes eléctricos que se ven habitualmente en las ciudades y constituyen la pieza final de la infraestructura eléctrica para suministrar electricidad al usuario final.

Cuando el desarrollador de un centro de datos necesita una capacidad eléctrica superior a la que tiene actualmente la empresa eléctrica local, normalmente es él quien debe pagar las mejoras necesarias en la infraestructura. Además, incluso si el desarrollador determina que es económicamente viable seguir adelante con dicha inversión, no hay garantía de que la empresa eléctrica local pueda suministrar en un plazo razonable. Los retos de la cadena de suministro afectan al sector de la energía eléctrica.

Los desarrolladores de centros de datos suelen mantener equipos estandarizados en toda su cartera, pueden preordenar equipos con años de anticipación y predecir razonablemente cuánta capacidad pueden implementar. Esta estrategia de preorden no se extiende a los equipos de infraestructura externos, ya que cada empresa de servicios públicos puede tener diferentes diseños y especificaciones de productos.

Los sistemas de energía (UPS, generadores, subestaciones y distribución) suelen representar alrededor del 40 a 45% del costo total.

Potencia para arrendamientos

A diferencia de los arrendamientos inmobiliarios tradicionales, los arrendamientos de centros de datos se basan en la potencia en vatios en lugar de en los metros cuadrados, lo que pone de relieve la naturaleza centrada en la potencia de las operaciones de los centros de datos y la importancia crítica del suministro de energía para sus usuarios. Los megavatios (MW) y los kilovatios (KW) son las unidades de medida básicas actuales en el sector. A medida que el sector crece, se utilizan cada vez más los gigavatios (GW), especialmente para medir el suministro y la absorción en un mercado determinado o a nivel nacional.

Sistemas de refrigeración

La refrigeración de un centro de datos es una tarea importante y el equipo mecánico necesario supera con creces los sistemas tradicionales de climatización utilizados en los inmuebles comerciales.

Por tanto, construir un centro de datos implica inversiones significativas en sistemas de refrigeración, que representan una parte sustancial tanto del costo de construcción (CapEx) como del costo operativo (OpEx). En proyectos de tamaño medio (aproximadamente de 800 kW), se estima que la refrigeración representa entre el 15 % y 20 % del CapEx total, mientras que el conjunto de “energía y refrigeración” puede representar hasta el 60 % del presupuesto, con la energía en sí misma consumiendo del 40 % al 45 % del CapEx.

Diseño y construcción

Debido a su diseño austero, el método de construcción predominante es el de hormigón prefabricado, comparable a los métodos utilizados para construir edificios industriales. Esto implica construir grandes encofrados, rellenarlos con hormigón y, a continuación, utilizar grúas para colocar las paredes en su sitio. El techo está compuesto por vigas de acero, cubiertas metálicas y una membrana de techado. La ventaja clara de este enfoque es el importante ahorro de costos y la rapidez con la que se pueden construir, lo que los convierte en una opción eficiente para la construcción de centros de datos a gran escala.

Las instalaciones tienden a parecerse mucho entre sí. Los desarrolladores de centros de datos crean un diseño estandarizado que se adapta a sus objetivos informáticos y de refrigeración y luego lo replican varias veces en todo el sitio.

En lugar de adaptar el diseño al terreno y diseñar un gran edificio, seleccionan un terreno lo suficientemente grande como para albergar los múltiples edificios de su diseño y los construyen uno tras otro. Por ejemplo, la instalación estándar de AWS está diseñada para suministrar entre 25 y 32 MW; para aumentar la potencia disponible en un sitio determinado, se construye el mismo edificio varias veces.

Esta estandarización tiene muchas ventajas claras. La primera es que el diseño de sus instalaciones se ha optimizado a lo largo de muchas iteraciones para equilibrar las cargas eléctricas, informáticas y de refrigeración. Solo se necesitan pequeños ajustes para cumplir con las normas locales o las condiciones climáticas. Los equipos de construcción están familiarizados con el diseño, lo que minimiza las interpretaciones o preguntas sobre el terreno. Además, los materiales de construcción y el equipo técnico pueden proyectarse y encargarse con años de antelación. Los gastos operativos anuales pueden proyectarse en toda la cartera, realizando ligeros ajustes para tener en cuenta los matices específicos de cada zona geográfica.

Por su parte, la construcción de un centro de datos requiere empresas constructoras especializadas certificadas en una serie de normas técnicas, ya que estas instalaciones son mucho más complejas que los edificios comerciales o industriales estándar. Un centro de datos debe albergar equipos informáticos altamente sensibles y funcionar de forma continua con un tiempo de inactividad mínimo, se exige una integración precisa de sistemas eléctricos, mecánicos y estructurales avanzados. A diferencia de los proyectos habituales de oficinas o almacenes, los centros de datos deben adaptarse a una conectividad de fibra de alta capacidad, un cableado complejo, sistemas UPS (sistema de alimentación ininterrumpida) y sistemas avanzados de climatización. Todos estos elementos deben funcionar a la perfección para evitar sobrecalentamientos, cortes de suministro o fallos de seguridad. Para cumplir estas normas, normalmente se requieren constructores con experiencia demostrada en infraestructuras de misión crítica.

Adquisición de equipos de TI

Estos equipos incluyen servidores, sistemas de almacenamiento, switches, routers y firewalls, así como el software y licencias asociadas para su funcionamiento. La magnitud de esta inversión depende del nivel de redundancia que se requiera, la densidad de racks planificada y el tipo de aplicaciones que se alojarán (por ejemplo, cargas de trabajo de inteligencia artificial requieren GPUs de alto costo, lo que incrementa sustancialmente el gasto).

Además, en centros de datos de hiperescala o de colocación, la diversidad de clientes puede requerir arquitecturas más flexibles que eleven el costo inicial, dado que deben soportar distintos entornos de virtualización, seguridad y conectividad.

Finalmente, cabe destacar que el peso del gasto en equipos de TI dentro del CapEx varía según el modelo de negocio del data center (Weinschenk, 2024, TAdviser, 2025). En un data center corporativo propio, el porcentaje puede superar el 20% del total del CapEx, dado que la infraestructura está diseñada a la medida de las necesidades de la empresa. En cambio, en data centers de colocación o hiperescala, el operador suele enfocarse más en infraestructura eléctrica, refrigeración y seguridad, dejando que los clientes instalen parte del hardware, lo que reduce el componente de CapEx en TI en la inversión inicial.

A diferencia de otros componentes del CapEx, los equipos de TI son además los que más rápido se deprecian. Mientras que un sistema eléctrico o de refrigeración puede mantenerse operativo por 10–15 años con mantenimiento adecuado, la vida útil de servidores y dispositivos de red suele estar en el rango de 3 a 5 años, obligando a ciclos de renovación más frecuentes. Por esto, muchas veces el CapEx inicial se acompaña de una estrategia de financiamiento o de modelos híbridos con leasing de hardware para reducir el impacto de la reposición.

ii. Gastos operativos (OpEx)

El OpEx agrupa todos los gastos necesarios para operar el centro de datos en el día a día. La mayor parte corresponde a la energía eléctrica, que puede representar entre el 30% y el 50% de los costos operativos, ya que es necesaria tanto para alimentar los servidores como para mantener la refrigeración. También se incluyen los costos de personal especializado, seguridad física, mantenimiento de equipos, enlaces de telecomunicaciones redundantes, seguros e impuestos. Según estimaciones de la industria, el OpEx anual equivale aproximadamente a un 5 a 10% del CapEx inicial, lo que significa que un centro de datos con un CapEx de 100 millones de dólares puede gastar entre 5 y 10 millones de dólares al año en operaciones.

Consumo de energía eléctrica

La energía es un gasto operativo continuo y muy importante. No obstante, eso no significa que todos los centros de datos vayan a concentrarse en las zonas con las tarifas eléctricas más bajas. De acuerdo a Fawcett (2024), una comparación entre los estados con las tarifas eléctricas más bajas (según datos de la Administración de Información Energética, EIA) y la cantidad de centros de datos en funcionamiento (por MW), revela que no existe una relación lineal entre ambos. Estados como Oklahoma, Nuevo México y Arkansas, a pesar de su electricidad barata, tienen algunas instalaciones de centros de datos, pero no muchas. Parece que hay otros factores, además de los bajos costos de electricidad, que influyen en las decisiones de selección de la ubicación de los centros de datos.

Personal y capacitación

Otro costo operativo importante relacionado con las instalaciones de los centros de datos es el personal. Los ingenieros de redes son responsables de mantener el tiempo de actividad garantizado por estas instalaciones. Sus funciones consisten en instalar y configurar nuevo hardware y realizar el mantenimiento rutinario.

Aunque no hay datos exactos sobre el número de empleados que se necesitan para operar un centro de datos, los expertos del sector han estimado que se necesita aproximadamente un empleado o contratista a tiempo completo por cada MW de potencia contratada a gran escala. Es importante señalar que esta cifra es muy subjetiva y dependerá en gran medida de la estructura de niveles de tiempo de actividad y de las normas adoptadas por cada operador individual.

Esta función requiere una formación constante y la incorporación de nuevo personal para garantizar que el personal esté capacitado para trabajar con todas las tecnologías. Una preocupación práctica con el desarrollo de nuevas instalaciones es garantizar que haya suficiente personal en los alrededores para dotar de personal a la instalación. Muchos lugares que parecen atractivos resultan difíciles de gestionar a largo plazo porque es complicado atraer y retener talento en zonas remotas.

Agua como OpEx

No existen cifras claras o estandarizadas sobre el porcentaje exacto que representa el consumo de agua dentro del OpEx (gastos operativos) de un centro de datos: la información disponible se enfoca más en volúmenes absolutos (litros o dólares totales) que en porcentajes respecto al gasto total operativo. La razón puede ser que el consumo es muy variable: depende del tipo de refrigeración, ubicación climática, sistemas de reutilización, etc., y pareciera no haber un valor representativo uniforme.

Con todo, un informe de Bluefield Research (2025) proyecta que para 2030, los gastos relacionados con el agua (tanto CapEx como OpEx) en centros de datos de EE. UU. alcanzarán los USD 797 millones anuales, sin embargo, no se especifica qué proporción representa del OpEx total.